Czy sztuczna inteligencja zrewolucjonizuje rynek sztuki?

Sztuczna inteligencja od lat rewolucjonizuje różne dziedziny naszego życia prywatnego i zawodowego, wchodząc w nowe obszary i dając nam niesamowite możliwości. Przyzwyczajono nas, że pojawia się w rozwiązaniach z zakresu medycyny, edukacji, a nawet zarządzania przestrzenią, jednak w kontekście sztuki przez wiele lat była czymś marginalnym. Dziś jednak to się zmienia - w raporcie podsumowującym trendy na przyszły rok Business Insider stwierdzał, że „następny jednorożec będzie generatorem wspartym AI”.

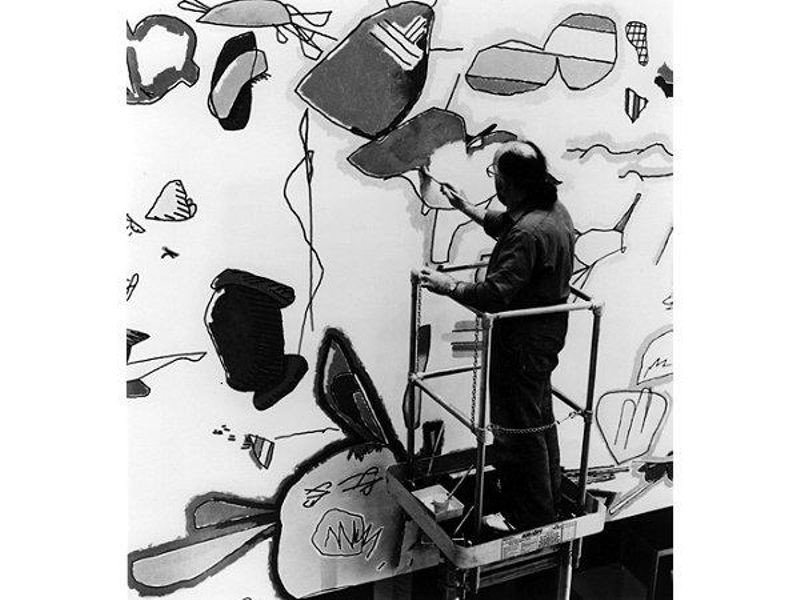

Sztuka jest pojęciem bardzo subiektywnym, istnieje jej wiele definicji, a granice tego czym jest, są nieustannie przesuwane. W dzisiejszym świecie jej postrzeganie jest czymś zupełnie innym niż sto czy nawet dziesięć lat temu. Sztuczna inteligencja i sztuka to połączenie, które funkcjonuje w powszechnej świadomości od niedawna. Jednak mało osób wie, że jednym z pierwszych systemów wykorzystujących algorytmy sztucznej inteligencji w sztuce, jest system AARON stworzony przez Harolda Cohena już na początku lat 60-tych. Celem Cohena było stworzenie rozwiązania, w ramach którego byłby w stanie zakodować proces rysowania. Przez lata AARON tworzył prymitywne czarno-białe rysunki, które autor rozwiązania kończył malując. Cohen “nauczył” też AARON-a jak malować z użyciem specjalnych farb i pędzli, które były wybierane przez program samodzielnie bez jego ingerencji.

Artyści zaczęli szerzej używać sztucznej inteligencji od 2014 roku kiedy zaprojektowano GANs - generative adversarial networks (generatywne sieci przeciwstawne). Jest to nowy sposób tworzenia sztucznej inteligencji opracowany przez Iana Goodfellow pozwalający komputerom tworzyć unikalne obrazy i utwory muzyczne. GAN to dwie sieci neuronowe: pierwsza (generator) próbuje stworzyć obraz nieodróżnialny od prawdziwego z bazy wzorcowych danych, podczas gdy druga (dyskryminator) stara się znaleźć różnice. Sieci trenują siebie nawzajem, co prowadzi do osiągania rezultatów w coraz lepszej jakości.

W 2015 roku Google wypuścił na rynek Deep Dream - narzędzie, wykorzystujące sztuczną inteligencję do przekształcania zdjęć w taki sposób, że wyglądają jak wyjęte z surrealistycznych snów. Niedługo później pojawiło się wiele aplikacji pozwalających na przerabianie zdjęć w obrazy wykorzystujące style znanych artystów.

Istnieje wiele programów używających sztucznej inteligencji do generowania obrazów za pomocą tekstowych wytycznych. Należą do nich narzędzia takie jak DALL-E firmy OpenAI, Imagen and Parti Google Brain (zespół naukowców działający w ramach Google AI - części Google dedykowanej rozwojowi sztucznej inteligencji) czy NUWA-Infinity Microsoft. Danymi wejściowymi mogą być zarówno obrazy, jak i słowa kluczowe takie jak styl artystyczny danego twórcy.

W sierpniu 2022 roku powstało Stable Diffusion, które sprawiło, że technologia ta jest dużo bardziej dostępna, również dla indywidualnego użytkownika. W listopadzie 2022 roku firma Stability AI wydała Stable Diffusion 2.0 - narzędzie o tej samej nazwie, które w ulepszonej wersji, nie tylko kreuje niesamowite grafiki, ale także ulepsza te, będące w niskiej jakości. Nowe oprogramowanie zapewnia szereg udogodnień i daje wiele możliwości, a modele tekstowo-obrazowe są trenowane za pomocą nowego kodera o nazwie OpenCLIP. Karmiąc sieć neuronową ogromną liczbą odpowiednio opisanych grafik, Stable Diffusion jest w stanie generować obrazy na podstawie komend tekstowych, dzięki czemu wykorzystanie technologii w sztuce weszło na kolejny, nieosiągalny dotychczas poziom.

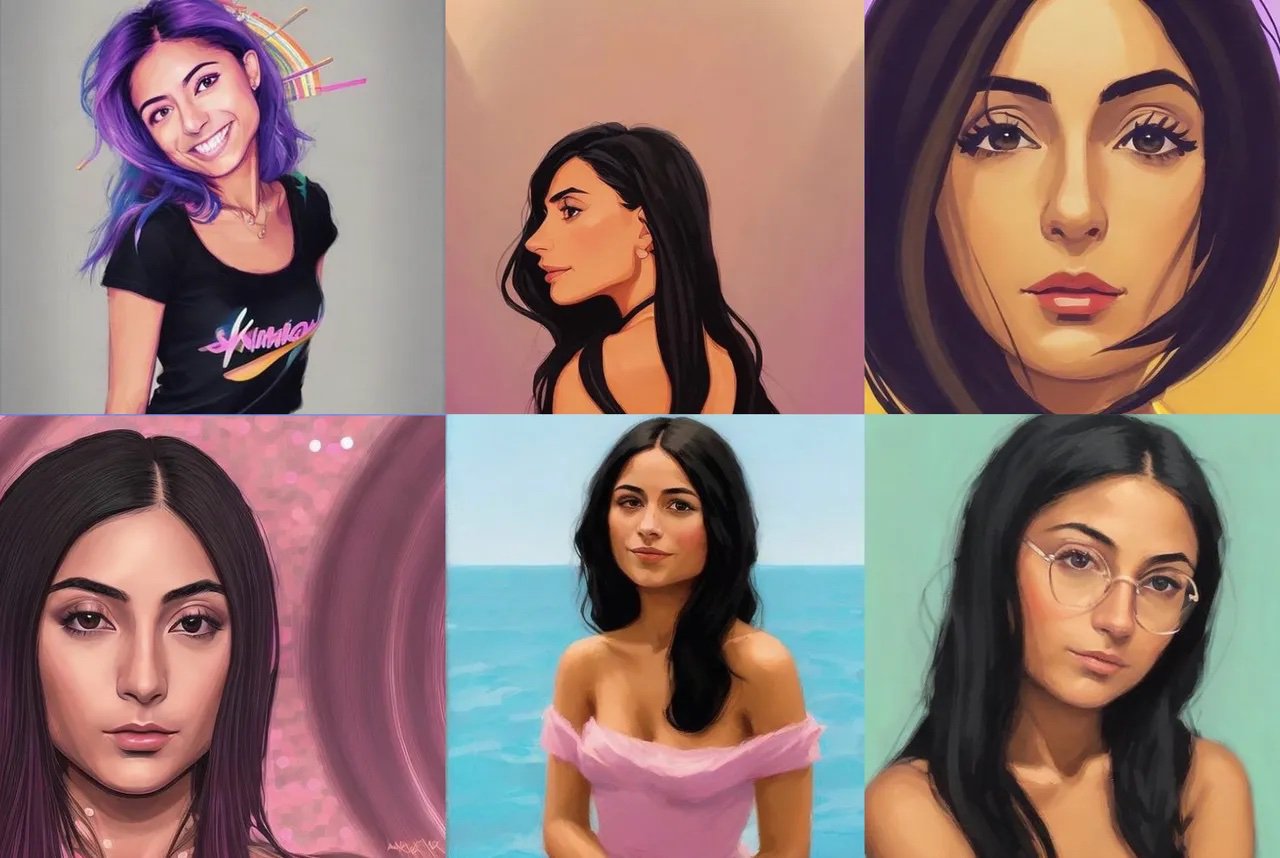

Od kilku tygodni Instagram i Facebook zalewają zdjęcia awatarów wygenerowanych przez aplikację Lensa AI. Oprogramowanie powstało w 2018 roku jako aplikacja do edycji zdjęć, ale od tego czasu mocno się rozwinęło. Obecnie za niewielką opłatą (na początku można skorzystać z wersji darmowej) na podstawie 10-20 selfie, aplikacja wygeneruje nam portrety w różnych stylach graficznych. Narzędzie daje nam możliwość otrzymania grafik niemal od razu, a jej popularność, poza feedem w naszych mediach społecznościowych, gdzie znajomi pokazują efekty jej pracy, świadczy fakt, że w sklepie Google Play została pobrana ponad 10 mln razy i jest obecnie numerem jeden najbardziej dochodowych aplikacji w kategorii ,,fotografia”.

W sierpniu tego roku szeroką debatę na temat wykorzystania nowych technologii w procesie tworzenia, wywołał lokalny konkurs sztuki organizowany w stanie Kolorado w USA. Projektant gier komputerowych Jason Allen zgłosił do konkursu Colorado State Fair Fine Arts Competition, pracę wykonaną za pomocą aplikacji Midjourney i zdobył pierwsze miejsce w kategorii sztuka cyfrowa/fotografia zmanipulowana cyfrowo. Grafika "Théâtre D'opéra Spatial" wywołała falę dyskusji, ponieważ aplikacja Midjourney tworzy obrazy po wydaniu tekstowych wytycznych, co wielu uznało za niewystarczający wkład człowieka w procesie twórczym, pomimo tego, że regulamin konkursu nie zakazywał podobnych ingerencji. Padło najważniejsze pytanie - Czy obrazy tworzone przez sztuczną inteligencję można w ogóle nazywać sztuką?

Lensa AI wywołuje równie wiele kontrowersji. Z jednej strony związane są one z dostępem do naszych danych, z drugiej pojawiają się głosy od użytkowniczek, że ich portrety są seksualizowane - wysyłają samą twarz a dostają zdjęcie eksponujące piersi, czy też oskarżenia o rasizm - aplikacja “poprawia” twarze Azjatów, żeby wyglądali jeszcze bardziej azjatycko. Jednak największym zarzutem wobec aplikacji, jest to, że okrada artystów. Aplikacja korzysta ze wspomnianego wcześniej Stable Diffusion, którego bazą wyjściową było ponad 2 miliardy zdjęć z internetu, dzięki czemu może tworzyć grafiki w stylu science fiction, fantasy czy anime. Jak twierdzą artyści, nie wszystkie prace z których korzystała aplikacja były darmowe - niektóre pochodziły z płatnych serwisów, jednak nikt za wykorzystanie ich prac nie zapłacił. W mediach społecznościowych pojawiają się doniesienia, że niektóre z prac miały znaki wodne, a ich pozostałości są widoczne w portretach generowanych przez AI.

To, co jest prawdą o polityce i moralności, wydaje się odnosić również do sztuki - napisał Jarvis we wstępie do koncepcji. - Podobnie jak większość ludzi jestem zapalonym konsumentem popkultury i nieustannie szukam nowych programów, filmów, książek, mody i muzyki - dodał. Jarvis zadaje kolejne pytania -co więc wiemy o popkulturze, co może być dla nas bardziej interesujące niż jakiekolwiek inne pytanie dotyczące popkultury? To pytania, na które nie musimy odpowiadać, po prostu musimy je zadać.

Jarvis został opracowany przez DERAFFE Wien, kierowany przez Răzvana Ionescu, rumuńskiego inżyniera, który zaprogramował algorytm wyboru artystów i opracował koncepcję kuratorską opartą na szeregu parametrów.

W Harvard Art Museums mieści się metaLAB – laboratorium wiedzy i projektowania oraz studio produkcyjne eksperymentujące w dziedzinie sztuki i nauk humanistycznych. Jednym z projektów jest „Curatorial A(i)gents”, seria inicjatyw opartych na rozwoju uczenia maszynowego w różnych obszarach sztuki. Przykładem jest projekt, który wykorzystuje sztuczną inteligencję, a pogoda staje się kuratorem sztuki. Korzystając z danych pogodowych i obrazu nieba z kamery, niestandardowe oprogramowanie stale wybiera prace ze zbiorów muzeum, łącząc kolory pomiędzy obserwacjami meteorologicznymi a metadanymi obrazu.

Wierzę, że już wkrótce ludzie będą pracować ramię w ramię z kuratorami AI. Sztuczna inteligencja będzie więc odpowiedzialna za przeszukiwanie baz danych w ciągu kilku sekund, ale i tak człowiek będzie polegał na emocjach widzów i na ich podstawie dokona ostatecznej selekcji prac.

Innym połączeniem sztuki i technologii, może być proces twórczy wykorzystywany przez Sougwen Chung. Chińsko-kanadyjska artystka maluje swoje obrazy z pomocą robotów, a w swoich pracach testuje granice współpracy człowieka i maszyny. Według Chung wspólna przyszłość sztuki tworzonej ręką ludzką oraz ramieniem robota leży nie w tym, co tworzą, ale jak wykorzystują tę współpracę, by przekraczać granice sztuki i odkrywać jej nowe możliwości. Wykorzystując sztuczną inteligencję i robotykę, tworzy niezwykłe, pionierskie dzieła.

Sztuczna inteligencja w dziedzinie sztuki, może stworzyć niesamowite możliwości, jednak bez odpowiedniej edukacji, zmian w prawie, które uchroniłoby artystów i wyznaczały pewne ramy działania, bardzo szybko postęp technologiczny może być widziany jako coś wrogiego. Technologia powinna wypełniać lukę między człowiekiem a naturą, pozwolić człowiekowi zwiększać swój potencjał i sprawiać, że dzięki temu połączeniu będziemy mogli pójść jeszcze dalej w naszej kreatywności.